A Ética e o Surgimento das Máquinas de Tomada de Decisão

Artigo: “Ethics and the dawn of decision-making machines”

Escrito por Jonathan Shaw – Harvard Magazine

Janeiro-Fevereiro de 2019

Site: https://www.harvardmagazine.com/2019/01/artificial-intelligence-limitations

Tradução livre Projeto OREM®

EM 18 DE MARÇO DE 2018, por volta das 22h, Elaine Herzberg estava pedalando a bicicleta dela do outro lado de uma rua em Tempe, Arizona, quando ela foi atropelada e morta por um carro autônomo. Embora houvesse um operador humano ao volante, um sistema autônomo – inteligência artificial – estava no controle total.

Esse incidente, como outros envolvendo interações entre pessoas e tecnologias de IA, levanta uma série de questões éticas e protolegais. Que obrigações morais os programadores do sistema tinham para impedir que a sua criação tirasse uma vida humana? E quem foi o responsável pela morte de Herzberg? A pessoa no banco do motorista? A empresa testando as capacidades do carro? Os projetistas do sistema de IA ou mesmo os fabricantes de seu equipamento sensorial a bordo?

[Obs: O que caracteriza uma sociedade protolegal? Existem regras e procedimentos bem determinados para a administração de disputas nesses tipos de sociedade. Porém não há distinções entre regras (padrões sociais) e leis (conectando ações específicas a consequências específicas). Trata-se de um estágio intermediário. A sociedade legal é aquela que considera determinados atos como indesejáveis ao ponto de terem uma punição, requerendo uma forma de escrita desenvolvida. (In GAGARIN, Michael. Early greek law. Berkeley: University of California Press, 1986, p. 8-12).]

‘Inteligência artificial’ refere-se a sistemas que podem ser projetados para receber sugestões de seu ambiente e, com base nessas entradas, resolver problemas, avaliar riscos, fazer previsões e tomar ações. Na era anterior aos poderosos computadores e big data, esses sistemas foram programados por humanos e seguiram as regras da invenção humana, entretanto os avanços na tecnologia levaram ao desenvolvimento de novas abordagens.

Uma delas é o aprendizado da máquina, agora a área mais ativa da IA, na qual os métodos estatísticos permitem que um sistema ‘aprenda’ a partir dos dados e tome decisões, sem ser explicitamente programado. Esses sistemas combinam um algoritmo, ou séries de etapas para resolver um problema, com uma base de conhecimento ou fluxo – as informações que o algoritmo usa para construir um modelo do mundo.

As preocupações éticas sobre esses avanços concentram-se em um extremo no uso de IA em drones militares mortais ou no risco de que a IA possa derrubar sistemas financeiros globais. Mais perto de casa, a IA tem estimulado a ansiedade sobre o desemprego, já que os sistemas autônomos ameaçam substituir milhões de caminhoneiros e tornar obsoletos o Lyft e o Uber.

E além dessas considerações sociais e econômicas mais amplas, os cientistas de dados têm preocupações reais sobre viés, sobre implementações éticas da tecnologia e sobre a natureza das interações entre sistemas de IA e humanos, se esses sistemas devem ser implantados de maneira adequada e justa, mesmo nas aplicações mais mundanas.

Considere uma mudança social aparentemente prosaica: as máquinas já estão recebendo o poder de tomar decisões cotidianas que alteram a vida das pessoas. A inteligência artificial é capaz de agregar e avaliar grandes quantidades de dados que às vezes estão além da capacidade humana de analisar sem ajuda, permitindo assim que a IA faça recomendações de contratação, determine em segundos a credibilidade dos candidatos a empréstimos e preveja as chances de os criminosos reincidirem.

Mas tais aplicações levantam questões éticas preocupantes porque os sistemas de IA podem reforçar o que eles têm aprendido a partir de dados do mundo real, amplificando até mesmo riscos familiares, como preconceito racial ou de gênero. Os sistemas também são capazes de cometer erros de julgamento quando confrontados com cenários desconhecidos. E como muitos desses sistemas são ‘caixas pretas’, as razões para as decisões deles não são facilmente acessadas ou entendidas por humanos – e, portanto, difíceis de questionar ou sondar.

Exemplos não faltam. Em 2014, a Amazon desenvolveu uma ferramenta de recrutamento para identificar engenheiros de software que ela poderia querer contratar; o sistema rapidamente começou a discriminar as mulheres e a empresa o abandonou em 2017. Em 2016, a ProPublica analisou um sistema desenvolvido comercialmente que prevê a probabilidade de reincidência de criminosos, criado para ajudar os juízes a tomar melhores decisões sobre sentenças e descobriu que era tendenciosa contra os negros. Nos últimos dois anos, carros autônomos que dependem de regras e dados de treinamento para operar causaram acidentes fatais quando confrontados com feedback sensorial desconhecido ou entradas que os seus sistemas de orientação não podiam interpretar. O fato de desenvolvedores comerciais privados geralmente se recusarem a disponibilizar o seu código para análise, porque o software é considerado propriedade intelectual, é outra forma de falta de transparência – legal, em vez de técnica.

Enquanto isso, nada sobre os avanços na tecnologia, por si só, resolverá o problema subjacente e fundamental no coração da IA, o qual é que mesmo um algoritmo cuidadosamente projetado tem que tomar decisões com base em entradas a partir de um mundo real falho, imperfeito, imprevisível e idiossincrático.

Os cientistas da computação têm percebido mais cedo do que outros que a engenharia nem sempre é capaz de resolver tais problemas post hoc [depois disso], depois que um sistema tiver sido projetado.

Apesar dos avanços notáveis em áreas como privacidade de dados (consulte “The Privacy Tools Project, janeiro-fevereiro de 2017, link: https://www.harvardmagazine.com/2017/01/privacy-tools-project”) e claro entendimento dos limites da equidade algorítmica, a tomada de consciência de que as preocupações éticas têm que, em muitos casos, serem consideradas antes que um sistema seja implantado, levou à integração formal de um currículo da ética — ensinado por pessoas pós-doutoradas e estudantes de graduação em filosofia — em muitas aulas de ciência da computação em Harvard.

Discussões de longo alcance sobre o impacto social da IA no mundo estão ocorrendo entre cientistas de dados em toda a Universidade, bem como em Ethics and Governance of AI Initiative [Iniciativa de Ética e Governança de IA] lançada pelo Berkman Klein Center da Harvard Law School, juntamente com o MIT Media Lab [Site https://aiethicsinitiative.org/]. Esse foco cada vez maior na ética se originou com um antigo membro do corpo docente de ciência da computação.

A partir da Comunicação à Cooperação — e à Ética

‘ALGUNS ANOS ATRÁS’, diz a professora de ciências naturais de Higgins, Barbara Grosz, ‘Eu estava visitando amigos na Microsoft – o marido desenvolve sistemas de visão computacional – e nós fomos a algum lugar para caminhar. Na rodovia à nossa frente havia um caminhão, com um banheiro químico na traseira e uma bicicleta presa ao banheiro químico. ‘O que o meu sistema faria com essa coisa?’, o marido se perguntou. ‘Ele saberia como reagir a isso?’’ A resposta é, provavelmente não. É improvável que tal imagem faça parte de sua ‘experiência’ – a vasta coleção de imagens, laboriosamente marcadas por humanos, que formam os dados de treinamento de um sistema.

A fragilidade dos atuais sistemas de IA contrasta fortemente com a inteligência humana, que é robusta – capaz de aprender algo em um contexto e aplicá-lo rapidamente em outro. Mesmo que os computadores possam distinguir bicicletas de caminhões com banheiros químicos, eles têm dificuldade em reconhecer como eles podem ter se unido para viajar pela rodovia, com a bicicleta de lado, a 60 milhas por hora. (A exploração dessa vulnerabilidade de entrada é o assunto de ‘IA e ataques adversários’ site https://www.harvardmagazine.com/2019/01/ai-and-adversarial-attacks.)

Em outras palavras, a IA carece de bom senso e capacidade de raciocinar – mesmo que também possa fazer descobertas incríveis que nenhum humano poderia, como detectar terceiros ou interações de ordem superior (quando três ou mais variáveis têm que interagir para ter um efeito) em redes biológicas complexas. ‘Pare de pensar em robôs assumindo o controle‘, é como Grosz resume. ‘Nós temos mais a temer de sistemas burros que as pessoas pensam que são inteligentes do que de sistemas inteligentes que conhecem os seus limites.’

Grosz, que estudou matemática em Cornell e depois ciência da computação em Berkeley, trabalha com problemas de IA desde 1973, quando ela foi contratada como matemática pesquisadora no Centro de Inteligência Artificial da SRI International. Ela é considerada uma arquiteta do subcampo de IA dedicado a como os computadores geram e interpretam a fala e o texto humanos – ela ganhou o Lifetime Achievement Award da Association for Computational Linguistics em 2017 – e é capaz de recitar uma ladainha de maneiras pelas quais sistemas com capacidade de linguagem, como Alexa, Siri e Google ficam aquém. Eles sabem onde fica o pronto-socorro mais próximo, por exemplo, mas não que seja útil direcionar alguém com um tornozelo quebrado para ir até lá.

Como o trabalho dela de IA em linguagem é anterior às abordagens baseadas em dados para processamento de linguagem natural (consulte ‘A linguagem como um teste decisivo para IA’ https://www.harvardmagazine.com/2019/01/language-as-litmus-test-ai), Grosz desenvolveu uma abordagem baseada em modelo para representar o discurso humano de uma maneira que os computadores pudessem entender. Isso tem provado ser especialmente valioso para o campo porque isso a levou a refletir profundamente sobre a natureza da interação humano-computador e, mais tarde, ao imaginar um futuro em que computadores e humanos poderiam trabalhar juntos, para propor modelos teóricos para sistemas de IA colaborativos projetados para trabalhar em equipes com pessoas.

O trabalho dela em modelos computacionais de discurso vai muito além da programação de regras gramaticais. Compreender a intenção do locutor, a fim de determinar a estrutura de um diálogo e, assim, decifrar o significado da fala humana, foi uma estratégia-chave em que ela foi pioneira. A fala real, ela aponta, é cheia de digressões e mudanças de foco, citando um exemplo notável: a sua gravação do diálogo espontâneo quando uma pessoa tenta contar a outra via teletipo como montar um compressor de ar. (Bem no meio da conversa, um falante usa o pronome ‘isso’ para se referir a um objeto que não é mencionado há meia hora – e ambas as pessoas entendem exatamente o que se quer dizer.) A entonação, acrescenta ela, também é a chave para entender de outra forma frases ambíguas. ‘Você é um verdadeiro príncipe’ pode ser dito literal ou sarcasticamente, de maneiras que um computador tem que ser ensinado a entender.

A partir dessa pesquisa interdisciplinar fluíram princípios gerais sobre a natureza da interação humano-computador. Grosz, com uma estudante de doutorado Ece Kamar (agora pesquisadora sênior da Microsoft Research) desenvolveu uma teoria de ‘gerenciamento de interrupção’, por exemplo, para orientar a troca de informações entre um humano e um computador, a fim de tornar essa comunicação exponencialmente mais eficiente. E ela passou a acreditar, ao longo de uma longa carreira, que o melhor uso da IA envolve a integração desses sistemas com equipes humanas. Ela prevê um futuro que combina a velocidade e a proeza estatística de computadores inteligentes com talentos humanos inatos, não um futuro que coloque máquinas e humanos uns contra os outros – a maneira como o relacionamento é frequentemente enquadrado em descrições de sistemas de IA derrotando campeões mundiais no xadrez e pronto, ou substituição de pessoas no local de trabalho. Essa abordagem integrada sem dúvida representa a fronteira em sistemas de IA.

Quando Grosz começou a experimentar sistemas de IA baseados em equipes na área da saúde, ela e um pediatra de Stanford iniciaram um projeto que coordena o atendimento de crianças com doenças raras atendidas por muitas pessoas além dos pais, incluindo especialistas médicos, auxiliares de cuidados domiciliares, fisioterapeutas e professores de sala de aula. O cuidado dura anos, ela diz, e ‘nenhum ser humano que eu já encontrei pode acompanhar 15 outras pessoas e o que elas estão fazendo por longos períodos de tempo.’

Grosz, com a estudante de doutorado Ofra Amir (agora membro do corpo docente do Technion), começou analisando como as equipes de atendimento ao paciente funcionavam e desenvolveu uma teoria de trabalho em equipe para orientar as interações entre os membros humanos e um sistema de IA projetado para coordenar informações sobre o cuidado às crianças. Como havia feito com a linguagem, ela começou com os princípios gerais. ‘O que nós estamos tentando fazer, do ponto de vista teórico, é entender melhor como compartilhar informações’ naquele ambiente de equipe com vários membros ‘e depois construir ferramentas, primeiro para os pais e depois para os médicos.’

Um dos princípios fundamentais que ela e o seu colega, Sarit Kraus, professor da Bar-Ilan University, desenvolveram é que os membros da equipe não devem assumir tarefas para as quais não possuem o conhecimento ou a capacidade necessários. Essa é uma característica do bom trabalho em equipe humana, bem como uma característica-chave de ‘sistemas inteligentes que conhecem os seus limites.’ ‘O problema, não apenas com IA, mas com muita tecnologia que existe no mundo, é que ela não consegue fazer o trabalho que lhe foi atribuído’ – chatbots de atendimento ao cliente online interagindo via texto que ‘não conseguem entender o que você quer’ sendo um caso em questão. Esses sistemas poderiam ter sido projetados de maneira diferente, diz ela, para que as primeiras interações sejam com uma pessoa auxiliada por um computador; a pessoa estaria construindo um relacionamento com o cliente, enquanto examinava o que o computador estava claramente entendendo mal e o sistema, por sua vez, permitiria que a pessoa fornecesse uma resposta mais rapidamente. Quando tais fundamentos do projeto de sistemas inteligentes não são respeitados, os sistemas são considerados capazes de coisas que não podem fazer ou são usados de maneira ingênua e inadequada.

A abordagem altamente interdisciplinar de pesquisa de Grosz, informada pela linguística, filosofia, psicologia, economia e até mesmo um pouco de antropologia e sociologia, levou-a a pensar também sobre qual desses assuntos poderia melhor informar o ensino do design de sistemas de IA. Embora ela tenha ministrado um curso introdutório sobre IA de 1987 a 2001, época em que a sua aplicação permanecia amplamente teórica, o mundo havia mudado quando ela reiniciou o curso em 2013 e 2014, quando sistemas de IA totalmente operacionais estavam sendo implantados. Grosz percebeu que havia uma oportunidade de ensino na interação entre os desafios éticos apresentados pela IA e o bom design de sistemas.

Isso levou a uma das contribuições mais importantes de Grosz para o ensino da ciência da computação em Harvard: a ideia de que a ética deveria ser fortemente integrada a todos os cursos. No outono de 2015, ela introduziu um novo curso, ‘Design de Sistemas Inteligentes e Desafios Éticos.’ No ano seguinte, mais de 140 alunos se inscreveram para as 25 vagas da turma, incentivando-a a encorajar os seus colegas de ciência da computação a incorporar algum ensino de ética em seus próprios cursos. Como a maioria deles não tinha formação suficiente para se sentir confortável ensinando ética, ela começou uma colaboração com a professora de filosofia de Wolcott, Alison Simmons, que preside o departamento de filosofia. Juntos, elas trabalharam com colegas em suas respectivas áreas, alistando professores de ciência da computação dispostos a incluir módulos de ética em seus cursos de ciência da computação e estudantes de pós-graduação em filosofia para ensiná-los.

O objetivo dessa iniciativa ‘Embedded EthiCS’ [Harvard, site https://embeddedethics.seas.harvard.edu/], diz ela, é instruir as pessoas que construirão futuros sistemas de IA sobre como identificar e pensar em questões éticas. (A ciência da computação é agora a segunda maior concentração entre os alunos de graduação de Harvard; se os alunos de áreas relacionadas, como estatística ou matemática aplicada, forem incluídos, o total de matrículas excede substancialmente o de economia de alto escalão.) ‘A maioria desses desafios éticos não tem uma única resposta certa,’ ela aponta, ‘assim como [os estudantes] aprendem habilidades básicas de computação, eu queria que eles aprendessem habilidades básicas de raciocínio ético.’ Na primavera de 2017, quatro cursos de ciência da computação incluíram algum estudo de caso de ética. Naquele outono, eram cinco, depois 8 na primavera de 2018 e agora 18 no total, abrangendo assuntos de programação de sistemas a aprendizado de máquina e seus efeitos na justiça e privacidade, redes sociais e a questão da censura, robôs e trabalho e interação humano-computador.

Pesquisas com estudantes dessas turmas mostram que entre 80% e 90% aprovam o ensino de ética incorporada e desejam mais. ‘A minha fantasia,’ diz Grosz, ‘é que todo curso de ciência da computação, talvez com uma ou duas exceções, tenha um módulo de ética,’ de modo que, na formatura, todo concentrador veja que ‘a ética é importante em todos os campos – não apenas na IA.’ Ela e seus colegas querem que os estudantes aprendam que, para lidar com problemas como preconceito e a necessidade de interpretabilidade humana na IA, eles têm que projetar sistemas com princípios éticos em mente desde o início.

Tornando-se um Motorista de Boston

BEMIS PROFESSOR de direito internacional e professor de ciência da computação, Jonathan Zittrain, que é diretor do Berkman Klein Center for Internet and Society, tem lutado com esse objetivo de uma perspectiva protolegal. Na primavera de 2018, ele ministrou um curso com o diretor do MIT Media Lab, Joi Ito, explorando como as tecnologias de IA devem ser moldadas para levar em consideração o interesse público. Os veículos autônomos forneceram um estudo de caso particularmente notável que forçou os estudantes a confrontar a natureza das complexidades à frente, além do ‘dilema do bonde desgovernado’ de decidir quem ferir e quem salvar.

[Obs.: O dilema do bonde é um experimento mental para ilustrar e colocar à prova distintas teorias éticas.]

Uma vez que um carro é verdadeiramente autônomo, explica Zittrain, ‘Isso significa que se um mandado de prisão for emitido para alguém, na próxima vez que entrar em um veículo autônomo, as portas podem travar e o carro pode apenas levá-lo à delegacia de polícia mais próxima. Ou se alguém no carro declarar uma emergência? O carro pode impulsioná-los a 70 milhas por hora nas ruas da cidade até o hospital, enquanto todos os outros carros se abrem como o Mar Vermelho?’

Os estudantes da turma de Zittrain pensavam que sabiam como a discussão sobre veículos autônomos se desenrolaria. Mas quando ele fez uma pergunta muito simples – ‘O motorista deveria ser capaz de instruir o carro a ir a 130 quilômetros por hora?’ – eles foram confrontados com os dilemas morais de um designer. Se sim e o carro se envolvesse em um acidente naquela velocidade, o motorista seria o responsável? Ou a montadora seria responsável por permitir que o carro acelerasse? ‘As pessoas aceleram o tempo todo, no entanto, nós temos o conforto implícito de saber que não há praticamente nada que nós possamos fazer a respeito,’ observa Zittrain. ‘A premissa inicial compreensível [com veículos autônomos] é que, caramba, não há motorista e nós não podemos culpar um objeto inanimado como um carro. Parece que há uma escassez de responsabilidade’ – quando, na verdade, ‘há um excesso de responsabilidade.’ Os fabricantes, os projetistas de IA, os formuladores de políticas e o motorista podem ser responsabilizados.

E a situação vem a ser mais complexa se o sistema de IA do veículo mudar dinamicamente o seu comportamento à medida que ele ‘aprende’ com as experiências na estrada, aponta Zittrain. ‘Talvez, se dirigir o suficiente em Boston, ele venha a ser um motorista de Boston!’ Isso se aplica a muitos sistemas de aprendizagem e as soluções legais permanecem inexploradas. Talvez, ele sugere, se um designer de IA ou outro colaborador construir um sistema de aprendizado no qual o comportamento nem sempre pode ser previsto, haverá um preço em operar com essa incerteza.

O assunto é um nexo de investigação interdisciplinar, continua Zittrain. No Berkman Klein Center e no Media Lab do MIT, ele e seus colegas criaram um grupo chamado ‘Assembly’ que traz desenvolvedores de software de empresas externas em período sabático para trabalhar com estudantes e uns com os outros por alguns meses em alguns desses quebra-cabeças em IA e outros campos de ciência de dados. ‘A instrução de ética incorporada faz parte de um esforço para criar oportunidades para que os estudantes a partir de toda a Universidade possam se encontrar e trazer as ferramentas que estão aprendendo em suas respectivas escolas para lidar com esse tipo de coisa em equipes.’

‘Eu penso que isso é parte do que tornou o ensino e a pesquisa de Barbara [Grosz] tão influentes aqui. E tão atemporal. O ensino dela não é como intervir em um sistema de computador ou software para consertá-lo. É realmente pensar em um nível mais amplo sobre como as pessoas e as tecnologias devem interagir.’ Eles podem ser responsabilizados? Eles podem ser entendidos? Eles podem ser justos?

Viés Sistêmico e Engenharia Social

O PROBLEMA da equidade em sistemas autônomos foi apresentado com destaque na Harvard Data Science Conference (HDSC) inaugural em outubro, onde o professor de ciência da computação David Parkes delineou princípios orientadores para o estudo da ciência de dados em Harvard: isso deve abordar questões éticas, incluindo privacidade (ver ‘The Watchers’, janeiro-fevereiro de 2017, página 56, site https://www.harvardmagazine.com/2017/01/the-watchers); isso não deve perpetuar vieses existentes; e isso deve ser transparente. Entretanto, criar sistemas de IA de aprendizado que incorporem esses princípios pode ser difícil. A complexidade do sistema, quando milhares ou mais variáveis estão em jogo, é capaz de fazer com que o verdadeiro entendimento seja quase impossível e vieses nos conjuntos de dados nos quais os sistemas de aprendizado dependem podem ser facilmente reforçados.

Existem muitas razões pelas quais alguém pode querer examinar ou investigar um sistema de IA para descobrir como ele tomou uma decisão específica: para avaliar a causa da saída tendenciosa, para executar verificações de segurança antes do lançamento em um hospital ou para determinar a responsabilidade após um acidente envolvendo um carro autônomo.

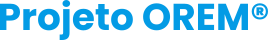

Cortesia de Finale Doshi-Velez

O que pode não ser óbvio é o quão difícil e complexo pode ser tal investigação. O professor assistente de ciência da computação Finale Doshi-Velez demonstrou projetando na tela uma árvore de decisão relativamente simples, com quatro camadas de profundidade, que envolvia responder a perguntas com base em cinco entradas (veja um exemplo um pouco mais complexo, acima). Se executada corretamente, a instrução final era levantar a mão esquerda. Alguns dos participantes da conferência puderam acompanhar. Então ela mostrou uma árvore de decisão muito mais complexa, talvez com 25 camadas de profundidade, com cinco novos parâmetros determinando o caminho da árvore até a resposta correta – uma tarefa fácil para um computador. Mas quando ela perguntou se alguém na platéia poderia descrever em palavras por que eles chegaram à resposta que chegaram, ninguém respondeu. Mesmo quando o caminho correto para uma decisão é destacado, é extremamente difícil descrever a influência de entradas interativas complexas no resultado em termos leigos. E isso é apenas para modelos simples, como árvores de decisão, não para arquiteturas profundas e modernas com milhões de parâmetros. Desenvolver técnicas para extrair explicações de modelos arbitrários – sistemas escaláveis com um número arbitrário de variáveis, tarefas e resultados – é o assunto de pesquisa em seu laboratório.

O viés apresenta um conjunto diferente de problemas. Sempre que houver uma população diversa (diferentes por etnia, religião ou raça, por exemplo), explicou a [Gordon] McKay professora de ciência da computação, Cynthia Dwork, durante uma palestra do HDSC sobre justiça algorítmica, um algoritmo que determina a elegibilidade para, digamos, um empréstimo, deve tratar cada grupo da mesma maneira. Mas em sistemas de aprendizado de máquina, o próprio algoritmo (o procedimento passo a passo para resolver um determinado problema) constitui apenas uma parte do sistema. A outra parte são os dados. Em um sistema de IA que toma decisões de empréstimo automatizadas, o componente do algoritmo pode ser imparcial e completamente justo em relação a cada grupo, mas o resultado geral, depois que o algoritmo aprendeu com os dados, pode não ser. ‘Os algoritmos não têm acesso à verdade absoluta’ (linguagem de computador para veritas), explicou Dwork. Se houver viés nos dados usados para tomar a decisão, a própria decisão pode ser tendenciosa.

Existem maneiras de gerenciar esse problema. Uma delas é selecionar com muito cuidado os atributos candidatos que um algoritmo pode considerar. (Códigos postais, como bem conhecidos proxies [procuradores] para raça, são frequentemente eliminados.) Mas o viés consegue se infiltrar por meio de correlações com outras variáveis que o algoritmo usa – como sobrenomes combinados com dados de censo geográfico.

O viés contra grupos geralmente é capaz de ser resolvido por meio do design de algoritmo inteligente, disse Dwork, entretanto garantir a justiça para os indivíduos é muito mais difícil devido a uma característica fundamental da tomada de decisão algorítmica. Qualquer decisão desse tipo efetivamente traça uma linha – e, como Dwork apontou, sempre haverá dois indivíduos de grupos diferentes próximos à linha, um de cada lado, que são muito semelhantes entre si em quase todos os aspectos. E, no entanto, apenas um obterá um empréstimo.

Em alguns casos, corrigir o viés por meio do projeto do sistema pode ser uma abordagem insuficiente. Considere um sistema de contratação projetado pelo professor de ciência da computação Yiling Chen, de McKay e pela estudante de pós-graduação Lily Hu ’15, para eliminar o viés de contratação contra os Afro-Americanos, historicamente um grupo desfavorecido. Como Hu coloca, ‘Algoritmos, que são ferramentas puramente voltadas para a otimização, podem herdar, internalizar, reproduzir e exacerbar as desigualdades existentes. Digamos que nós temos uma disparidade no mercado de trabalho que persiste sem qualquer tipo de ajuda de aprendizado de máquina e aí vem o aprendizado de máquina e aprende a reinscrever essas desigualdades.’ A solução deles, que usa ferramentas da economia e da sociologia para entender as disparidades no mercado de trabalho, leva o pensamento sobre justiça algorítmica além da ciência da computação para uma visão interdisciplinar e abrangente do problema.

Chen trabalha em computação social, uma área da ciência de dados que enfatiza o efeito do comportamento humano nas entradas de algoritmos. Como os humanos são ‘interessados, independentes, propensos a erros e não previsíveis‘ o suficiente para permitir o design de um algoritmo que garantisse a justiça em todas as situações, ela começou a pensar em como eliminar o viés dos dados de treinamento – os dados reais de entradas de informações mundiais que um algoritmo de contratação usaria.

Ela e Hu se concentraram no problema da implementação de ações afirmativas na contratação. Um remédio direto para neutralizar a desvantagem histórica enfrentada por um grupo minoritário seria, simplesmente, favorecer esse grupo nas decisões de emprego, todas as outras coisas sendo iguais. (Isso pode ser considerado injusto para o grupo majoritário, mas ainda assim considerado aceitável até que a equidade na contratação seja alcançada.) Mas Chen e Hu então consideraram o elemento humano. Suponha que muitos dos membros do grupo minoritário não façam faculdade, argumentando que ‘isso é caro e, devido à discriminação, mesmo que eu consiga um diploma, as chances de conseguir um emprego ainda são baixas’. Os empregadores, por sua vez, podem acreditar que ‘pessoas de grupos minoritários são menos educadas e não têm um bom desempenho porque não se esforçam muito.’ O argumento de Chen e Hu é que, embora a decisão de um membro de um grupo minoritário de não frequentar a faculdade seja racional, com base na injustiça histórica existente, essa decisão reforça as ideias preconcebidas dos empregadores sobre o grupo como um todo. Esse padrão de efeitos de feedback não é apenas difícil de quebrar – é precisamente o tipo de padrão de dados que um algoritmo, olhando para contratações bem-sucedidas anteriores e associando-as a diplomas universitários, irá reforçar.

A solução que Chen e Hu propõem não se baseia apenas na matemática: em vez disso, é uma engenharia social que usa um algoritmo para mudar a verdade básica. E representa um reconhecimento de quão difícil pode ser neutralizar o viés nos dados. O que os pesquisadores propõem é a criação de um mercado de trabalho temporário. Pense nisso, diz Chen, como um estágio no qual todo candidato a emprego deve participar por dois anos antes de ser contratado para a força de trabalho permanente. A entrada no pool de estágio estaria sujeita a uma simples ‘restrição de justiça’, um algoritmo que exigiria que os empregadores escolhessem estagiários de grupos minoritários e majoritários em números representativos. Então, na conclusão do estágio, a contratação do grupo de estagiários seria baseada exclusivamente em dados de desempenho, sem levar em consideração a associação ao grupo. Como os grupos são igualmente talentosos no nível da população, explica Chen, os dois grupos acabam alcançando a paridade.

‘O que esse artigo está tentando combater’, explica Hu, ‘é a percepção – ainda dominante na comunidade de aprendizado de máquina/IA – de que tudo é fundamentalmente um problema de otimização, um problema de previsão ou um problema de classificação. E quando você faz isso – se você tratar isso de uma forma padrão de aprendizado de máquina – você acabará reforçando essas desigualdades.’

Hu foi a professora do curso de Grosz em IA e ética (co-ensinado com o colega de filosofia Jeffrey Behrends) no ano passado. Ela diz que as pessoas necessitam entender que o ato de ‘Construir tecnologias e a maneira como as implementamos são, em si, ações políticas. Elas não existem no vácuo, como ferramentas instrumentais que às vezes são boas, às vezes são ruins. Acho que essa é uma maneira particularmente ingênua de pensar em tecnologia.’

Quer a tecnologia seja destinada a fornecer reconhecimento facial para identificar suspeitos de crimes a partir de imagens de vídeo, ou educação adaptada a diferentes estilos de aprendizagem, ou aconselhamento médico, Hu enfatiza: ‘O que nós necessitamos pensar é como as tecnologias incorporam determinados valores e suposições. Expor isso é um primeiro passo: perceber que não é o caso que existem algumas questões éticas e algumas questões não éticas, mas realmente que, em tudo o que nós projetamos… sempre haverá questões normativas em mãos, durante todo o processo.’ Integrar essa consciência no nível da realidade [awareness] aos cursos existentes é fundamental para garantir que ‘o mundo que nós estamos construindo, com tecnologia onipresente, seja um mundo em que nós queremos viver’.

Jonathan Shaw ’89 é o editor-chefe dessa revista.

—–

Inteligência Artificial e Ética no Google

Leia o Memorando de Ética de IA do Google: ‘Nós não estamos desenvolvendo IA para uso em armas’

Artigo, em Inglês, extraído do site: https://www.cnet.com/tech/tech-industry/read-googles-ai-ethics-memo-we-are-not-developing-ai-for-use-in-weapons/

No entanto, o CEO Sundar Pichai diz que a empresa ainda trabalhará com os militares.

Artigo escrito por Richard Nieva e Sean Hollister (7 de junho de 2018)

Tradução livre Projeto OREM®

James Martin / CNET

“Depois que os próprios funcionários do Google protestaram contra o Project Maven, um contrato de defesa do Pentágono que eles imaginavam que a empresa estava ajudando drones militares a ganharem a habilidade de rastrear objetos, a empresa prometeu que ela iria emitir diretrizes éticas sobre o uso de inteligência artificial.

Agora, essas diretrizes estão aqui.

‘Nós reconhecemos que uma tecnologia tão poderosa levanta questões igualmente poderosas sobre o seu uso. Como a IA é desenvolvida e usada terá um impacto significativo na sociedade por muitos anos’, disse o CEO do Google, Sundar Pichai, em um post de blog na quinta-feira. ‘Como líder em IA, nós sentimos uma profunda responsabilidade de fazer isso direito.’

Pichai disse que a empresa não desenvolverá ‘tecnologias que causem ou possam causar danos gerais’, armas projetadas para prejudicar, tecnologias de vigilância que ‘violem normas internacionalmente aceitas‘ ou tecnologias que violem ‘princípios amplamente aceitos do direito internacional e dos direitos humanos.’

No entanto, Pichai acrescenta que a empresa continuará trabalhando com militares e governos em outras áreas.

Embora Pichai os exponha como ‘princípios’ em oposição a regras estritas, a seção do memorando sobre armas é intitulada ‘aplicações de IA que nós não buscaremos.’

A ética da IA tem se tornado uma questão polêmica que tem perturbado a empresa recentemente. Os funcionários têm contestado a decisão da empresa de participar do Maven, uma iniciativa que visa desenvolver uma melhor inteligência artificial para os militares dos EUA. Os Googlers estavam divididos quanto ao papel do empregador deles em ajudar a desenvolver tecnologia que pudesse ser usada na guerra. Mais de 4.000 funcionários teriam assinado uma petição dirigida a Pichai exigindo que a empresa cancelasse o projeto. Na semana passada, o Google disse que ela não renovaria o contrato do Maven ou buscaria contratos semelhantes.

As novas diretrizes do Google podem definir o tom da maneira como a indústria de tecnologia lida com o desenvolvimento da inteligência artificial daqui para frente. A postura da gigante das buscas também pode influenciar a forma como outras empresas estruturam as políticas delas sobre trabalho com os militares.

Pichai tem repetidamente dito que o futuro do Google é como uma empresa ‘AI-first’. Essa filosofia tem colocado o Google em maus lençóis no passado. No mês passado, Pichai revelou uma nova tecnologia chamada Google Duplex, uma IA incrivelmente realista que pode fazer reservas para jantares e salões de beleza para pessoas por telefone. O software usa tiques verbais e pausas, o que pode levar a pessoa do outro lado da linha a pensar que o robô é humano.

Os críticos da empresa disseram que isso é antiético pelo fato do software operar sem se identificar para as pessoas com quem interage. O Google por fim esclareceu que ele poderia desenvolver o produto com divulgações claras.

Na reunião anual do Google com os acionistas na quarta-feira, Pichai não abordou especificamente essas questões, entretanto mencionou a responsabilidade da empresa em acertar esses tipos de coisas.

‘A tecnologia é capaz de ser uma força tremendamente positiva’, disse ele. ‘No entanto também levanta questões importantes sobre como nós devemos aplicá-la no mundo. Nós estamos fazendo a nós mesmos todas essas perguntas.‘

Aqui está todo o memorando:

IA no Google: os nossos princípios

Em sua essência, a IA é a programação de computadores que aprende e se adapta. Ela não é capaz de resolver todos os problemas, entretanto o seu potencial para melhorar as nossas vidas é profundo. No Google, nós usamos IA para fazer com que os produtos sejam mais úteis – desde e-mails livres de spam e mais fáceis de escrever, até um assistente digital com quem você pode falar naturalmente, até fotos que mostram coisas divertidas para você aproveitar.

Além de nossos produtos, nós estamos usando IA para ajudar as pessoas a resolver problemas urgentes. Um par de estudantes do ensino médio está construindo sensores alimentados por IA para prever o risco de incêndios florestais. Os agricultores o estão usando para monitorar a saúde de seus rebanhos. Os médicos estão começando a usar IA para ajudar a diagnosticar o câncer e prevenir a cegueira. Esses benefícios claros são o motivo pelo qual o Google investe pesadamente em pesquisa e desenvolvimento de IA e faz com que as tecnologias de IA sejam amplamente disponíveis para outras pessoas por meio de nossas ferramentas e código-aberto.

Nós reconhecemos que tal tecnologia tão poderosa levanta questões igualmente poderosas sobre o seu uso. A maneira como a IA é desenvolvida e usada terá um impacto significativo na sociedade por muitos anos. Como líderes em IA, nós sentimos uma profunda responsabilidade de fazer isso direito. Então, hoje, nós estamos anunciando sete princípios para orientar o nosso trabalho daqui para frente. Esses não são conceitos teóricos; são padrões concretos que governarão ativamente a nossa pesquisa e desenvolvimento de produtos e afetarão as nossas decisões de negócios.

Nós reconhecemos que essa área é dinâmica e em evolução e nós abordaremos o nosso trabalho com humildade, um compromisso com o envolvimento interno e externo e uma disposição para adaptar a nossa abordagem à medida que nós aprendemos com o tempo.

Objetivos para aplicativos de IA

Nós avaliaremos as aplicações de IA tendo em vista os seguintes objetivos. Nós acreditamos que a IA deve:

1. Ser socialmente benéfica.

O alcance ampliado das novas tecnologias atinge cada vez mais a sociedade como um todo. Os avanços na IA terão impactos transformadores em uma ampla gama de campos, incluindo saúde, segurança, energia, transporte, manufatura e entretenimento. Ao considerarmos o potencial desenvolvimento e uso de tecnologias de IA, nós levaremos em consideração uma ampla gama de fatores sociais e econômicos e prosseguiremos quando nós acreditarmos que os benefícios gerais prováveis excedem substancialmente os riscos e desvantagens previsíveis.

A IA também aumenta a nossa capacidade de entender o significado do conteúdo em escala. Nós faremos o possível para disponibilizar informações precisas e de alta qualidade prontamente usando IA, continuando a respeitar as normas culturais, sociais e legais dos países onde nós operamos. E nós continuaremos a avaliar cuidadosamente quando fazer com que as nossas tecnologias estejam disponíveis de forma não comercial.

2. Evitar criar ou reforçar preconceitos injustos.

Os algoritmos e conjuntos de dados de IA podem refletir, reforçar ou reduzir preconceitos injustos. Nós reconhecemos que distinguir preconceitos justos de injustos nem sempre é simples e difere entre culturas e sociedades. Nós procuraremos evitar impactos injustos sobre as pessoas, especialmente aqueles relacionados a características sensíveis como raça, etnia, gênero, nacionalidade, renda, orientação sexual, capacidade e crença política ou religiosa.

3. Ser construído e testado quanto à segurança.

Nós continuaremos a desenvolver e aplicar fortes práticas de segurança e proteção para evitar resultados não intencionais que criem riscos de danos. Nós projetaremos os nossos sistemas de IA para serem adequadamente cautelosos e nós buscaremos desenvolvê-los de acordo com as melhores práticas em pesquisa de segurança de IA. Nos casos apropriados, nós testaremos as tecnologias de IA em ambientes restritos e monitoraremos a sua operação após a implantação.

4. Ser responsável perante as pessoas.

Nós projetaremos sistemas de IA que forneçam oportunidades apropriadas para feedback, explicações relevantes e recursos. As nossas tecnologias de IA estarão sujeitas à direção e controle humanos apropriados.

5. Incorporar princípios de privacidade desde a concepção.

Nós incorporaremos os nossos princípios de privacidade no desenvolvimento e uso de nossas tecnologias de IA. Nós daremos oportunidade para notificação e consentimento, encorajaremos arquiteturas com salvaguardas de privacidade e forneceremos transparência e controle apropriados sobre o uso de dados.

6. Manter altos padrões de excelência científica.

A inovação tecnológica está enraizada no método científico e no compromisso com a investigação aberta, o rigor intelectual, a integridade e a colaboração. As ferramentas de IA têm o potencial de abrir novos domínios de pesquisa científica e conhecimento em domínios críticos como biologia, química, medicina e ciências ambientais. Nós aspiramos a altos padrões de excelência científica enquanto nós trabalhamos para progredir no desenvolvimento da IA.

Nós trabalharemos com diversas partes interessadas para promover uma liderança ponderada nessa área, com base em abordagens multidisciplinares e cientificamente rigorosas. E nós compartilharemos com responsabilidade o conhecimento de IA publicando materiais educacionais, práticas recomendadas e pesquisas que permitam que mais pessoas desenvolvam aplicativos de IA úteis.

7. Ser disponibilizada para usos que estejam de acordo com esses princípios.

Muitas tecnologias têm usos múltiplos. Nós trabalharemos para limitar aplicativos potencialmente nocivos ou abusivos. À medida que nós desenvolvemos e implantamos tecnologias de IA, nós avaliaremos os usos prováveis à luz dos seguintes fatores:

• Propósito e uso primários: se o propósito primário e o uso provável de uma tecnologia e sua aplicação, incluindo o quanto a solução está relacionada ou adaptável a um uso nocivo

• Natureza e singularidade: se nós estamos disponibilizando tecnologia única ou disponível de forma mais geral

• Escala: se o uso dessa tecnologia terá impacto significativo

• Natureza do envolvimento do Google: se nós estamos fornecendo ferramentas de uso geral, integrando ferramentas para clientes ou desenvolvendo soluções customizadas

Aplicativos de IA que nós não buscaremos

Além dos objetivos acima, nós não projetaremos ou implantaremos IA nas seguintes áreas de aplicação:

Tecnologias que causam ou possam causar danos gerais. Onde houver um risco material de danos, nós procederemos apenas quando nós acreditarmos que os benefícios superam substancialmente os riscos e incorporaremos as restrições de segurança apropriadas.

Armas ou outras tecnologias cujo principal objetivo ou implementação é causar ou facilitar diretamente ferimentos em pessoas.

Tecnologias que coletam ou usam informações para vigilância violando normas internacionalmente aceitas.

Tecnologias cuja finalidade violam os princípios amplamente aceitos do direito internacional e dos direitos humanos.

Nós queremos deixar claro que, embora nós não estejamos desenvolvendo IA para uso em armas, nós continuaremos o nosso trabalho com governos e militares em muitas outras áreas. Isso inclui segurança cibernética, treinamento, recrutamento militar, assistência médica de veteranos e busca e salvamento. Essas colaborações são importantes e nós procuraremos ativamente mais maneiras de aumentar o trabalho crítico dessas organizações e manter os militares e civis seguros.

IA para o longo prazo

Embora seja assim que nós estamos escolhendo abordar a IA, nós entendemos que há espaço para muitas vozes nessa conversa. À medida que as tecnologias de IA progridem, nós trabalharemos com várias partes interessadas para promover uma liderança ponderada nessa área, com base em abordagens multidisciplinares e cientificamente rigorosas. E nós continuaremos a compartilhar o que nós temos aprendido para melhorar as tecnologias e práticas de IA.

Nós acreditamos que esses princípios são a base certa para a nossa empresa e o desenvolvimento futuro da IA. Essa abordagem é consistente com os valores originais estabelecidos em nossa Carta dos Fundadores em 2004. Nela, nós deixamos clara a nossa intenção em adotar uma perspectiva de longo prazo, mesmo que isso signifique fazer compensações de curto prazo. Nós dissemos isso lá atrás e nós acreditamos nisso agora.”

Imagem possessed-photography-U3sOwViXhkY-unsplash.jpg – 21 de agosto de 2023

—–